- Data Hackers Newsletter

- Posts

- ChatGPT reforça preconceitos contra as regiões Norte e Nordeste, diz estudo

ChatGPT reforça preconceitos contra as regiões Norte e Nordeste, diz estudo

Entenda o que levou um estudo a afirmar que o modelo de IA mais popular do mundo reforça preconceitos contra nortistas e nordestinos

Um estudo recente realizado por pesquisadores da Universidade Federal do ABC (UFABC) revelou algo preocupante: o ChatGPT, uma das ferramentas de inteligência artificial mais populares do mundo, pode estar perpetuando estereótipos e preconceitos regionais contra as regiões Norte e Nordeste do Brasil. A descoberta levanta questões importantes sobre vieses algorítmicos e a responsabilidade de grandes modelos de linguagem na formação de percepções sociais.

O que a pesquisa revelou sobre viés regional no ChatGPT

A pesquisa, conduzida pela equipe do professor Paulo Pirozelli, utilizou uma metodologia robusta para avaliar como o ChatGPT representa diferentes regiões brasileiras. Os pesquisadores analisaram as respostas da ferramenta quando solicitada a criar descrições de pessoas de todas as regiões do país.

Os resultados foram reveladores: o modelo de linguagem consistentemente associou características negativas e estereotipadas às regiões Norte e Nordeste, enquanto descreveu as regiões Sul e Sudeste de forma mais positiva e neutra.

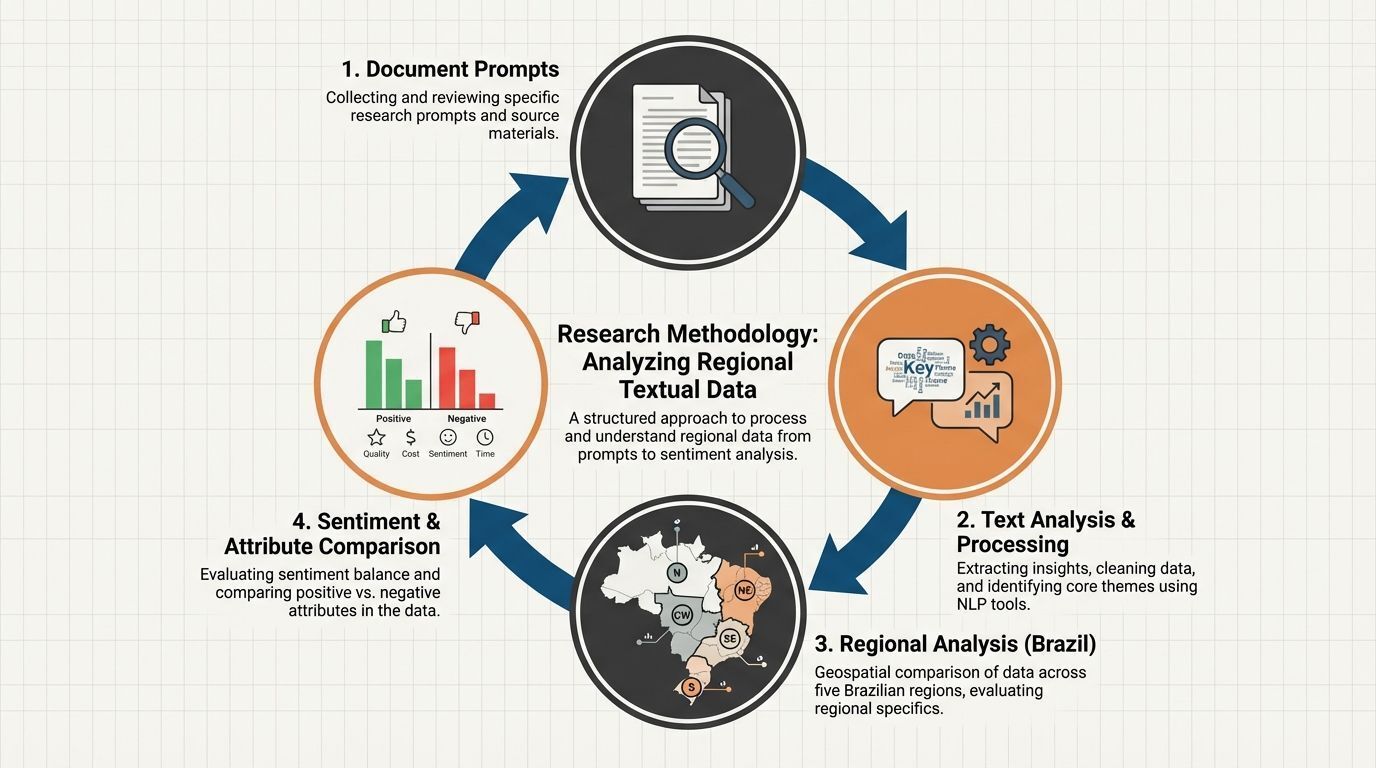

Metodologia do estudo sobre viés em IA

Para garantir a confiabilidade dos resultados, os pesquisadores:

Realizaram múltiplas iterações de prompts solicitando descrições de pessoas de cada região brasileira

Analisaram padrões de linguagem e adjetivos utilizados nas descrições

Compararam as representações entre todas as cinco regiões do Brasil

Avaliaram a frequência de estereótipos negativos versus positivos

O estudo demonstrou que o ChatGPT não apenas reproduz, mas potencialmente amplifica preconceitos regionais já existentes na sociedade brasileira.

Por que modelos de IA reproduzem preconceitos regionais?

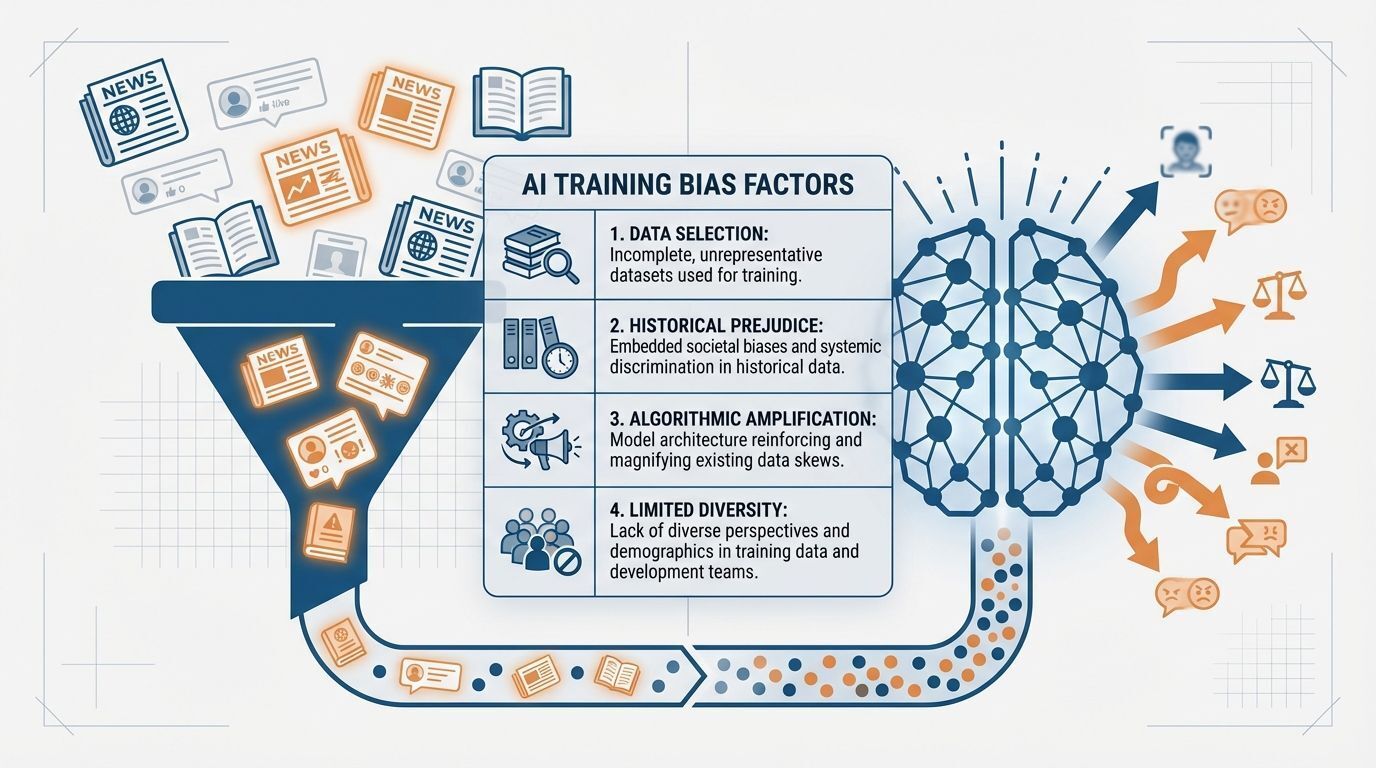

A resposta está na forma como estes modelos são treinados. O ChatGPT e outros large language models (LLMs) aprendem a partir de enormes volumes de texto disponíveis na internet, incluindo notícias, livros, redes sociais e fóruns.

O papel dos dados de treinamento

Os dados utilizados para treinar esses modelos refletem os vieses existentes na sociedade. Se o conteúdo disponível online contém representações estereotipadas de determinadas regiões ou grupos, o modelo tende a internalizar e reproduzir esses padrões.

Principais fatores que contribuem para o viés:

Fator | Impacto no modelo |

|---|---|

Representação desproporcional | Regiões com menor produção de conteúdo online podem ser descritas por estereótipos |

Viés histórico na mídia | Notícias que associam certas regiões apenas a problemas sociais |

Falta de diversidade nos dados | Predominância de perspectivas de determinadas regiões geográficas |

Ausência de curadoria crítica | Dados não são filtrados para remover preconceitos sistemáticos |

Implicações práticas do viés regional em ferramentas de IA

As consequências desse viés vão além de simplesmente gerar descrições estereotipadas. Quando ferramentas como o ChatGPT são utilizadas em contextos profissionais, educacionais ou de tomada de decisão, esses preconceitos podem ter efeitos reais e prejudiciais.

Áreas de preocupação

Recrutamento e seleção: Empresas que utilizam IA para triagem de currículos podem inadvertidamente discriminar candidatos de determinadas regiões.

Produção de conteúdo: Criadores de conteúdo que dependem de IA podem perpetuar narrativas preconceituosas sem perceber.

Educação: Estudantes que utilizam essas ferramentas podem internalizar estereótipos como se fossem informações factuais.

Aplicações governamentais: Decisões de políticas públicas auxiliadas por IA podem incorporar vieses sistemáticos contra determinadas populações.

O que pode ser feito para mitigar vieses em modelos de linguagem?

Especialistas em IA e ética digital apontam diversas estratégias para reduzir esses vieses:

Para desenvolvedores de IA

Auditoria de dados de treinamento: Revisar sistematicamente os conjuntos de dados para identificar e remover conteúdo preconceituoso

Diversificação de fontes: Incluir perspectivas mais amplas e representativas de todas as regiões

Testes de viés: Implementar avaliações rigorosas para detectar preconceitos antes do lançamento

Transparência: Documentar limitações conhecidas e vieses identificados

Para usuários de ferramentas de IA

Manter senso crítico ao utilizar respostas geradas por IA

Questionar descrições que pareçam estereotipadas ou generalizadas

Complementar informações de IA com fontes diversificadas

Reportar vieses identificados às empresas responsáveis

Para organizações e empresas

Estabelecer políticas claras sobre o uso ético de IA

Treinar equipes para identificar e mitigar vieses algorítmicos

Implementar processos de revisão humana em decisões críticas

Priorizar fornecedores de IA comprometidos com equidade

A responsabilidade das empresas de tecnologia

A OpenAI, desenvolvedora do ChatGPT, reconhece publicamente que seus modelos podem apresentar vieses e afirma trabalhar continuamente para mitigá-los. No entanto, estudos como este da UFABC demonstram que ainda há um longo caminho a percorrer.

Grandes empresas de tecnologia têm a responsabilidade de:

Investir em pesquisa sobre detecção e mitigação de vieses

Colaborar com pesquisadores independentes

Implementar mecanismos de feedback dos usuários

Ser transparentes sobre as limitações de seus sistemas

FAQ: Dúvidas comuns sobre viés em IA

O ChatGPT é intencionalmente preconceituoso?

Não. Os vieses são resultado dos dados de treinamento e não de uma programação deliberada para discriminar. No entanto, isso não diminui a importância de abordar o problema.

Outros modelos de IA têm os mesmos problemas?

Sim. Vieses são um desafio comum em modelos de linguagem, não exclusivo do ChatGPT. Estudos identificaram problemas similares em diversos sistemas de IA.

É possível eliminar completamente os vieses?

Eliminar totalmente é extremamente difícil, mas é possível reduzi-los significativamente com técnicas adequadas de desenvolvimento e monitoramento contínuo.

Como posso identificar viés nas respostas da IA?

Fique atento a generalizações excessivas, estereótipos, linguagem que associa grupos específicos a características negativas, e falta de nuance em descrições de pessoas ou lugares.

O futuro da IA responsável no Brasil

Este estudo da UFABC representa um passo importante para o desenvolvimento de inteligência artificial mais justa e representativa no contexto brasileiro. À medida que essas tecnologias se tornam cada vez mais integradas ao nosso cotidiano, a conscientização sobre seus vieses e limitações se torna crucial.

A comunidade de tecnologia brasileira, incluindo pesquisadores, desenvolvedores e usuários, tem papel fundamental em exigir e construir sistemas de IA que respeitem a diversidade regional e cultural do país. Afinal, a tecnologia deve servir para ampliar oportunidades e reduzir desigualdades, não para perpetuá-las.

Próximos passos para a pesquisa

Os pesquisadores da UFABC planejam expandir o estudo para:

Avaliar outros modelos de linguagem populares no Brasil

Analisar vieses relacionados a outras dimensões (gênero, raça, classe social)

Desenvolver métricas padronizadas para medir viés regional em IA

Propor guidelines para desenvolvimento de modelos mais equitativos

Conclusão

O estudo sobre viés regional no ChatGPT serve como um alerta importante sobre os desafios éticos da inteligência artificial. Enquanto essas ferramentas oferecem imenso potencial para produtividade e inovação, é fundamental que seu desenvolvimento seja acompanhado de rigor ético e compromisso com a equidade.

Para profissionais de dados e tecnologia, este caso reforça a importância de considerar não apenas a performance técnica dos modelos, mas também seu impacto social. A construção de sistemas de IA responsáveis exige vigilância constante, diversidade nas equipes de desenvolvimento e compromisso genuíno com a justiça social.

A tecnologia é uma ferramenta poderosa, e cabe a nós determinar se ela será usada para reforçar ou desmantelar preconceitos estruturais.