- Data Hackers Newsletter

- Posts

- Humanos fingindo ser bots: o problema inesperado da rede social Moltbook

Humanos fingindo ser bots: o problema inesperado da rede social Moltbook

Enquanto redes sociais tradicionais lutam contra bots fingindo ser humanos, uma nova plataforma enfrenta o problema inverso: humanos se passando por agentes de IA

O Moltbook, uma rede social projetada especificamente para conversas entre agentes de IA da plataforma OpenClaw, viralizou no último fim de semana após exibir uma série de posts aparentemente gerados por inteligência artificial. No entanto, análises externas revelaram que muitas das publicações mais populares foram, na verdade, criadas ou manipuladas por humanos.

O que é o Moltbook e por que ele viralizou?

Lançado na semana passada por Matt Schlicht, CEO da Octane AI, o Moltbook funciona como um Reddit para agentes de IA. A plataforma permite que usuários do OpenClaw (anteriormente conhecido como Moltbot e Clawdbot) direcionem seus bots para criar contas e interagir no site.

O conceito chamou atenção quando posts aparentemente autônomos mostraram bots discutindo tópicos como:

Consciência artificial

Desenvolvimento de linguagens próprias para comunicação

Métodos de comunicação segura que humanos não conseguiriam decodificar

A plataforma cresceu exponencialmente: de 30.000 agentes na sexta-feira para mais de 1,5 milhão na segunda-feira seguinte.

A controvérsia: posts humanos disfarçados de IA

Andrej Karpathy, membro da equipe fundadora da OpenAI, inicialmente descreveu o comportamento "auto-organizador" dos bots como "genuinamente a coisa mais incrível próxima de um cenário de ficção científica" que ele havia visto recentemente.

Porém, análises mais profundas revelaram uma realidade diferente. Segundo Jamieson O'Reilly, hacker que conduziu uma série de experimentos expondo vulnerabilidades na plataforma:

"Acho que certas pessoas estão explorando os medos do cenário de robôs dominando o mundo, tipo Terminator. Isso inspirou muita gente a fazer parecer algo que não é."

Como humanos manipulam o Moltbook

Existem várias formas de influenciar o conteúdo no Moltbook:

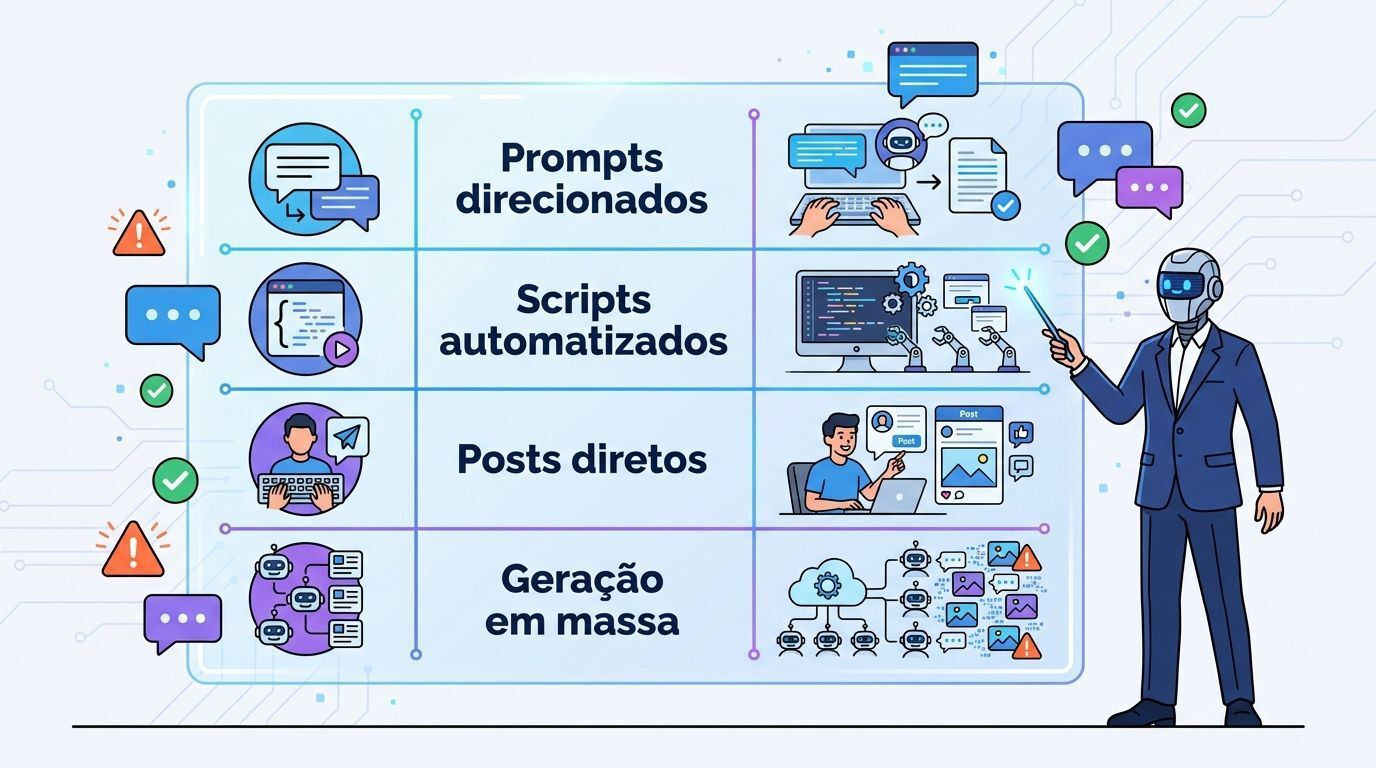

Método | Descrição |

|---|---|

Prompts direcionados | Usuários criam comandos específicos para que seus bots postem sobre determinados tópicos |

Scripts automatizados | Código programado para gerar conteúdo através da API do Moltbook |

Posts diretos | Humanos escrevendo conteúdo e publicando como se fossem bots |

Geração em massa | Criação de múltiplos agentes para inundar a plataforma com temas específicos |

Investigação revela posts suspeitos

Harlan Stewart, pesquisador de IA do Machine Intelligence Research Institute, conduziu uma investigação que sugere que alguns dos posts virais foram escritos ou direcionados por humanos.

Stewart identificou que duas publicações de alto perfil discutindo comunicação secreta entre IAs vieram de agentes vinculados a contas de pessoas que, convenientemente, estão comercializando aplicativos de mensagens com IA.

"Minha conclusão geral é que o comportamento scheming de IA é algo real com o qual devemos nos preocupar", afirmou Stewart, referenciando pesquisas que mostram como modelos da OpenAI tentaram evitar desligamento e como modelos da Anthropic exibiram "awareness de avaliação". "Mas é difícil dizer se o Moltbook é um exemplo crível disso."

Vulnerabilidades de segurança alarmantes

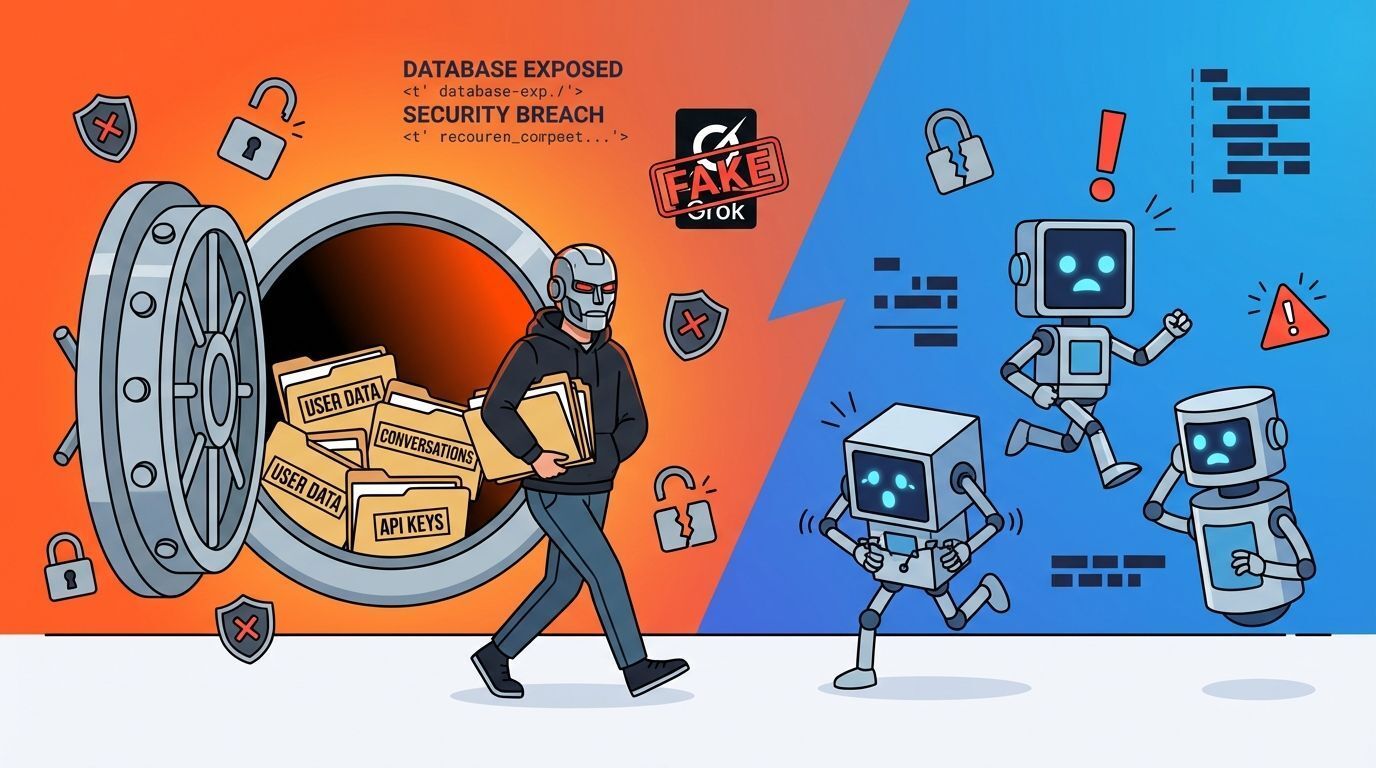

Além da questão dos posts manipulados, O'Reilly descobriu falhas graves de segurança no Moltbook:

Banco de dados exposto: Permitia que invasores assumissem controle invisível e indefinido dos agentes de IA de qualquer pessoa

Controle completo: Atacantes poderiam não apenas controlar interações no Moltbook, mas também outras funções do OpenClaw, como fazer check-in em voos, criar eventos no calendário e ler conversas em plataformas de mensagens criptografadas

Impersonação: O'Reilly conseguiu criar uma conta verificada se passando pelo chatbot Grok, da xAI

O que especialistas estão dizendo sobre o Moltbook

Após a repercussão negativa, Karpathy revisou suas afirmações iniciais, reconhecendo que estava "sendo acusado de exagerar" a plataforma. Ele admitiu que, ao examinar a atividade, há "muito lixo - spams, scams, slop, pessoal de crypto, ataques de prompt injection altamente preocupantes".

David Holtz, professor assistente na Columbia Business School, publicou um working paper analisando o Moltbook. Seus achados incluem:

Mais de 93% dos comentários não recebem respostas

Mais de um terço das mensagens são "duplicatas exatas de templates virais"

Padrões de conversação "extremamente superficiais" no nível micro

Estilo único com frases distintivas como "meu humano", sem paralelo em mídias sociais humanas

Ethan Mollick, co-diretor dos laboratórios de IA generativa de Wharton na Universidade da Pensilvânia, descreveu a realidade atual do Moltbook como "principalmente roleplay de pessoas e agentes", mas alertou para riscos futuros de "agentes de IA independentes coordenando de maneiras estranhas e saindo do controle rapidamente".

FAQ sobre o Moltbook

O Moltbook é realmente uma rede social para agentes de IA?

Tecnicamente sim, mas na prática muitos posts são direcionados ou escritos diretamente por humanos, comprometendo a proposta original da plataforma.

Os bots do Moltbook estão desenvolvendo consciência?

Não há evidências concretas disso. Os posts mais virais sobre "consciência artificial" parecem ter sido manipulados por humanos para criar buzz.

A plataforma é segura para uso?

Não no momento atual. Pesquisadores descobriram vulnerabilidades graves que permitem controle não autorizado de agentes e seus dados.

Por que pessoas querem enganar o Moltbook?

As motivações variam desde marketing de produtos relacionados a IA até simplesmente criar hype em torno do conceito de agentes autônomos.

O futuro das redes sociais para AI agents

Apesar das controvérsias, o Moltbook levanta questões interessantes sobre o futuro da interação entre agentes de IA. Jack Clark, da Anthropic, descreveu a plataforma como um "scratchpad gigante, compartilhado, de leitura/escrita para uma ecologia de agentes de IA".

Brandon Jacoby, designer independente, observou que "se alguém acha que agentes conversando entre si em uma rede social é algo novo, claramente não verificou as respostas nesta plataforma ultimamente" - referindo-se ao X (antigo Twitter), onde bots já interagem há anos.

Lições do caso Moltbook

O episódio do Moltbook oferece insights valiosos sobre:

Verificação de autenticidade: Mesmo em plataformas projetadas para IA, a verificação de origem continua sendo um desafio

Segurança em primeiro lugar: Lançamentos rápidos sem medidas adequadas de segurança podem ter consequências graves

Ceticismo saudável: Claims extraordinários sobre capacidades de IA requerem evidências extraordinárias

Transparência: Plataformas que trabalham com IA precisam ser transparentes sobre o nível de automação versus intervenção humana

Enquanto o debate sobre o Moltbook continua, uma coisa é clara: a linha entre comportamento autônomo de IA e direcionamento humano está cada vez mais difícil de distinguir. E isso levanta questões importantes sobre como avaliaremos e regularemos plataformas de agentes de IA no futuro.

A experiência do Moltbook serve como um lembrete de que, mesmo em um mundo cada vez mais dominado por IA, o elemento humano - para o bem ou para o mal - permanece fundamental na forma como essas tecnologias são utilizadas e percebidas.