- Data Hackers Newsletter

- Posts

- Ollama: aprenda a usar a ferramenta que roda LLM na sua máquina

Ollama: aprenda a usar a ferramenta que roda LLM na sua máquina

Um guia prático para usar o Ollama, uma excelente ferramenta para quem deseja experimentar LLMs localmente

O Ollama emergiu como uma das ferramentas mais práticas para desenvolvedores e entusiastas de inteligência artificial que desejam experimentar Large Language Models (LLMs) localmente. Com suporte para macOS, Windows e Linux, esta plataforma open-source democratiza o acesso a modelos de linguagem, permitindo que você execute modelos como Llama, Gemma e outros diretamente no seu computador.

Neste guia completo, vamos explorar como começar a usar o Ollama, desde a instalação até casos de uso avançados para desenvolvimento e integração com ferramentas populares.

O que é Ollama?

Ollama é uma plataforma que simplifica drasticamente o processo de executar LLMs localmente. Em vez de depender de APIs pagas ou serviços na nuvem, você pode rodar modelos poderosos diretamente na sua máquina, garantindo privacidade, controle total e sem custos por uso.

A ferramenta se destaca por sua interface intuitiva e fácil configuração, tornando acessível até mesmo para quem está começando no universo dos modelos de linguagem.

Primeiros passos com Ollama

Download e instalação

O primeiro passo é fazer o download do Ollama para o seu sistema operacional. A ferramenta está disponível para as principais plataformas: macOS, Windows e Linux. Acesse o site oficial e baixe a versão compatível com seu sistema.

Iniciando a interface interativa

Após a instalação, abra seu terminal e digite simplesmente:

ollama

Este comando abre um menu interativo que funciona como seu hub central para trabalhar com modelos. A navegação é simples e intuitiva:

↑/↓: Navegue entre as opções

Enter: Inicie o item selecionado

→: Mude o modelo

Esc: Saia do menu

O menu interativo oferece acesso rápido a três funcionalidades principais:

Funcionalidade | Descrição |

|---|---|

Run a model | Inicia um chat interativo com o modelo selecionado |

Launch tools | Acesso a ferramentas como Claude Code, Codex, OpenClaw |

Additional integrations | Integrações disponíveis no menu "More…" |

Usando Ollama para desenvolvimento

Ferramentas de código

Uma das aplicações mais poderosas do Ollama é na assistência ao desenvolvimento. A plataforma se integra nativamente com diversas ferramentas de coding:

Claude Code - Para iniciar o Claude com assistência de código:

ollama launch claude

Codex - Acesse o modelo especializado em programação:

ollama launch codex

OpenCode - Experimente alternativas open-source:

ollama launch opencode

Essas integrações transformam o Ollama em um copiloto de programação poderoso, executando completamente offline e sem compartilhar seu código com serviços externos.

Integração com IDEs e editores

O Ollama suporta integração com os principais editores de código e IDEs do mercado. Isso significa que você pode ter assistência de IA diretamente no seu ambiente de desenvolvimento favorito, seja VS Code, Vim, Emacs ou outros editores populares.

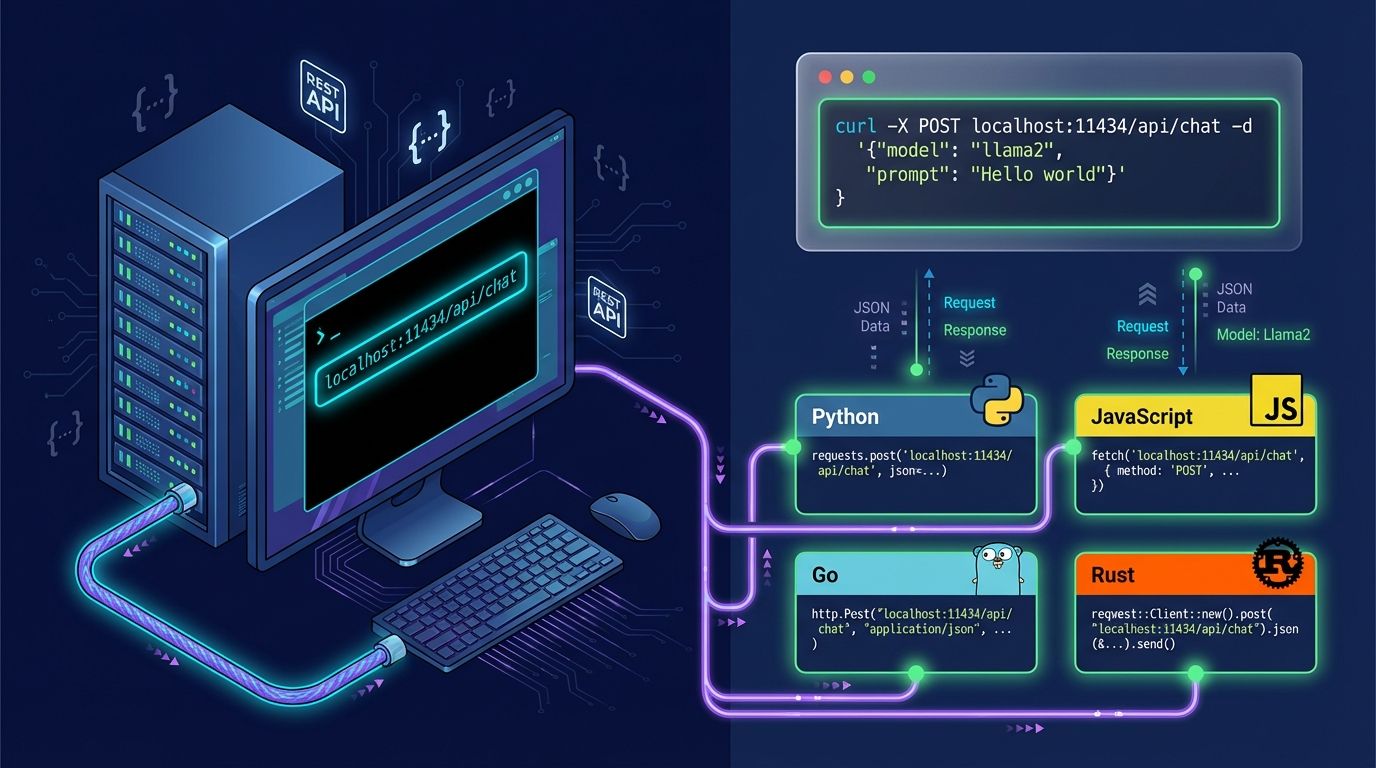

Trabalhando com a API do Ollama

Requisições básicas via cURL

A API do Ollama é REST-based e extremamente simples de usar. Aqui está um exemplo básico de como fazer uma requisição:

curl http://localhost:11434/api/chat -d '{

"model": "gemma3",

"messages": [{ "role": "user", "content": "Hello!" }]

}'

Esta requisição:

Conecta-se ao servidor local do Ollama (porta 11434)

Usa o endpoint

/api/chatEspecifica o modelo

gemma3Envia uma mensagem do usuário

Integrações em diferentes linguagens

O Ollama oferece suporte nativo para as linguagens de programação mais populares:

Python: Ideal para projetos de data science, machine learning e automação

JavaScript/Node.js: Perfeito para aplicações web e desenvolvimento full-stack

Go: Para aplicações de alta performance

Rust: Quando segurança e eficiência são prioridades

Todas essas integrações estão documentadas na documentação oficial da API, facilitando a implementação em qualquer stack tecnológico.

Capacidades avançadas do Ollama

Streaming de respostas

O Ollama suporta streaming de respostas, permitindo que sua aplicação exiba o texto conforme ele é gerado, similar ao comportamento do ChatGPT. Isso melhora significativamente a experiência do usuário em aplicações de chat.

Structured outputs

Para aplicações que precisam de dados estruturados, o Ollama pode retornar respostas em formatos específicos como JSON, facilitando a integração com sistemas existentes e pipelines de dados.

Vision e análise de imagens

Modelos multimodais no Ollama permitem análise de imagens, abrindo possibilidades para aplicações de visão computacional, OCR e análise de documentos visuais.

Embeddings

Gere embeddings de texto para aplicações de busca semântica, sistemas de recomendação e outras tarefas que envolvem similaridade entre textos.

Tool calling

Integre seus modelos com ferramentas externas, permitindo que eles executem ações como buscar informações em APIs, fazer cálculos ou interagir com bancos de dados.

Web search

Alguns modelos suportam busca na web diretamente, expandindo as capacidades de resposta com informações atualizadas da internet.

Cases de uso práticos

Chat e RAG (Retrieval-Augmented Generation)

O Ollama é ideal para construir sistemas de chat inteligentes e aplicações RAG, onde o modelo pode consultar documentos e bases de conhecimento para fornecer respostas mais precisas e contextualizadas.

Automação de tarefas

Integre o Ollama em scripts de automação para processar textos, gerar conteúdo, analisar documentos e muito mais, tudo rodando localmente sem depender de serviços externos.

Notebooks e experimentos

Para cientistas de dados e pesquisadores, o Ollama se integra perfeitamente com Jupyter Notebooks e outras ferramentas de experimentação, facilitando a prototipagem rápida.

Perguntas frequentes

O Ollama é gratuito?

Sim, o Ollama é completamente gratuito e open-source.

Preciso de uma GPU para usar o Ollama?

Não necessariamente. Embora uma GPU acelere significativamente o processamento, o Ollama pode rodar em CPU, especialmente com modelos menores.

Posso usar o Ollama em produção?

Sim, o Ollama pode ser usado em ambientes de produção, especialmente quando privacidade e controle de dados são prioritários.

Como escolher o modelo certo?

Depende do seu caso de uso. Modelos maiores são mais capazes mas exigem mais recursos. Comece com modelos menores como Gemma ou Llama 3B e escale conforme necessário.

O Ollama funciona offline?

Sim, após baixar os modelos, você pode usar o Ollama completamente offline.

Conclusão

O Ollama representa uma mudança significativa na forma como desenvolvedores e empresas podem trabalhar com LLMs. Ao eliminar a necessidade de APIs pagas e oferecer controle total sobre os dados, a ferramenta abre novas possibilidades para projetos que exigem privacidade, baixa latência ou simplesmente querem evitar custos recorrentes de API.

Com uma interface intuitiva, API robusta e suporte para as principais linguagens de programação, o Ollama se tornou rapidamente uma das ferramentas essenciais no toolkit de qualquer desenvolvedor que trabalha com IA.

Se você está começando sua jornada com LLMs ou procurando alternativas para reduzir custos e aumentar o controle sobre suas aplicações de IA, o Ollama é definitivamente uma ferramenta que vale a pena explorar.