- Data Hackers Newsletter

- Posts

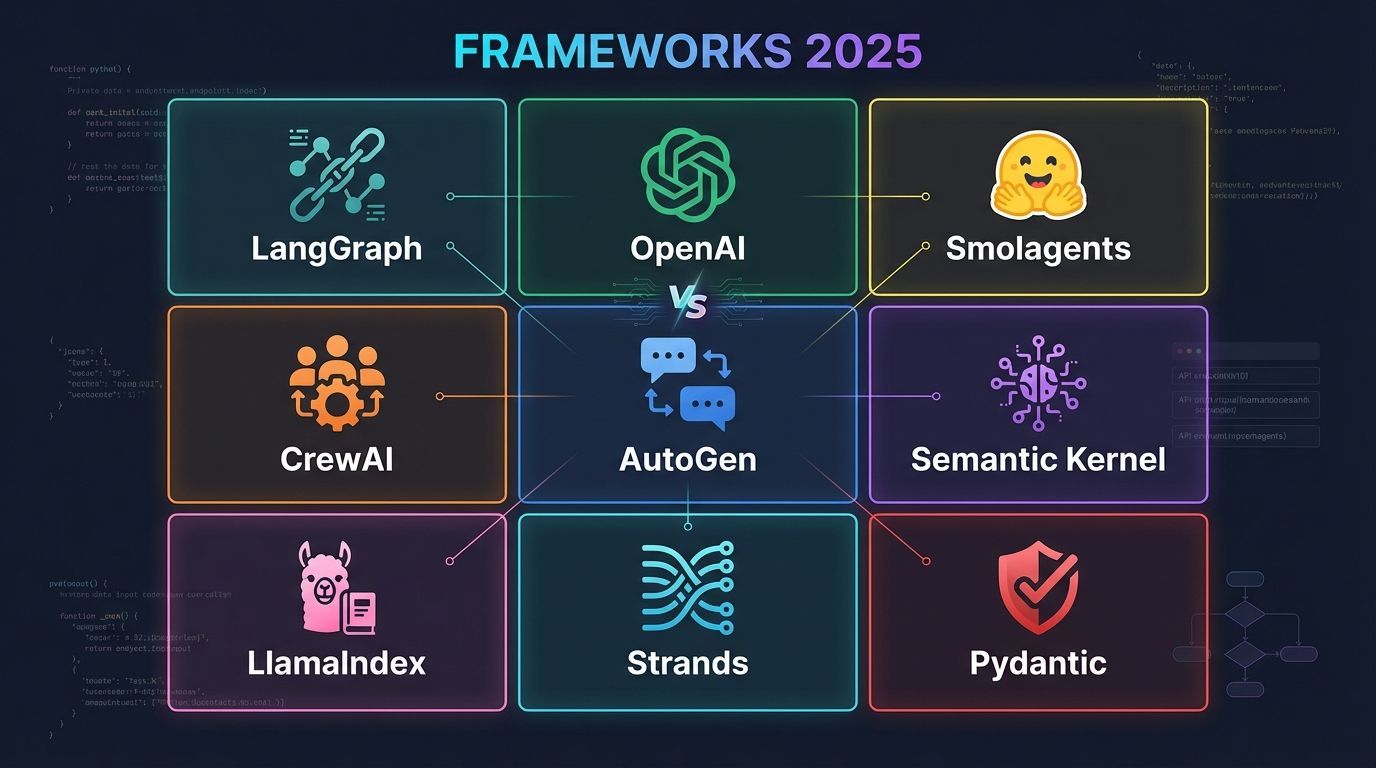

- Frameworks de agentes de IA em 2025: 9 opções open source comparadas

Frameworks de agentes de IA em 2025: 9 opções open source comparadas

Conheça 9 frameworks open source para criar agentes de IA e entenda qual se adapta melhor às suas necessidades

Construir agentes de IA costumava ser uma colcha de retalhos de scripts, engenharia de prompts e tentativa e erro. Hoje, existe um cenário crescente de frameworks open source projetados para simplificar o processo de criação de agentes que raciocinam, planejam e executam tarefas de forma autônoma. Este post oferece uma análise aprofundada de alguns dos principais frameworks de agentes de IA open source disponíveis: LangGraph, OpenAI Agents SDK, Smolagents, CrewAI, AutoGen, Semantic Kernel, LlamaIndex agents, Strands Agents e Pydantic AI agents. Ao terminar a leitura, você terá uma visão mais clara do ponto forte de cada framework, como eles diferem e onde se destacam no desenvolvimento real.

Um dos maiores desafios no desenvolvimento de agentes é encontrar o equilíbrio certo entre dar autonomia suficiente à IA para lidar com tarefas dinamicamente e manter estrutura suficiente para garantir confiabilidade. Cada framework tem sua própria filosofia, desde fluxos de trabalho explícitos baseados em grafos até agentes leves orientados por código. Vamos explorar suas ideias centrais, rastrear como eles podem se encaixar no seu fluxo de trabalho e examinar como você pode integrá-los com soluções de monitoramento como o Langfuse para avaliá-los e debugá-los, garantindo que funcionem em produção.

🦜 LangGraph

O LangGraph estende a conhecida biblioteca LangChain em uma arquitetura baseada em grafos que trata as etapas do agente como nós em um grafo direcionado acíclico. Cada nó lida com um prompt ou subtarefa, e as arestas controlam o fluxo de dados e transições. Isso é útil para tarefas complexas de várias etapas, onde você precisa de controle preciso sobre ramificações e tratamento de erros. A filosofia DAG do LangGraph facilita visualizar ou debugar como as decisões fluem de uma etapa para outra, e você ainda herda uma tonelada de ferramentas úteis e integrações do LangChain.

Desenvolvedores que preferem modelar tarefas de IA em workflows stateful geralmente gravitam em direção ao LangGraph. Se sua aplicação exige decomposição robusta de tarefas, ramificação paralela ou a capacidade de injetar lógica customizada em estágios específicos, você pode achar a abordagem explícita do LangGraph adequada.

Principais características:

Controle explícito através de DAGs

Integração nativa com o ecossistema LangChain

Suporte robusto para branching e error handling

Visualização clara do fluxo de decisões

OpenAI Agents SDK

O OpenAI Agents SDK é a mais recente entrada no campo. Ele empacota as capacidades da OpenAI em um conjunto de ferramentas mais estruturado para construir agentes que podem raciocinar, planejar e chamar APIs externas ou funções. Ao fornecer um runtime de agente especializado e uma API direta para atribuir roles, tools e triggers, a OpenAI visa simplificar a orquestração multi-step ou multi-agent. Embora ainda esteja evoluindo, os desenvolvedores apreciam o estilo familiar de prompts e a integração nativa com os endpoints de modelo da OpenAI.

Se você já está profundamente no stack da OpenAI e quer uma solução oficialmente suportada para criar agentes que utilizam GPT-4o ou GPT-o3, o OpenAI Agents SDK pode ser sua primeira parada.

Por que considerar:

Suporte oficial da OpenAI

Ferramentas integradas como web e file search

API simplificada para orquestração

Integração nativa com modelos GPT

🤗 Smolagents

O smolagents da Hugging Face adota uma abordagem radicalmente simples e centrada em código. Em vez de lidar com prompts complexos de múltiplas etapas ou orquestração avançada, o smolagents configura um loop mínimo onde o agente escreve e executa código para alcançar um objetivo. É ideal para cenários onde você quer um agente pequeno e autocontido que possa chamar bibliotecas Python ou executar computações rápidas sem construir um DAG completo ou fluxo de conversação multi-agente. Esse minimalismo é o principal ponto de venda: você pode definir algumas linhas de configuração e deixar o modelo descobrir como chamar suas ferramentas ou bibliotecas escolhidas.

Se você valoriza configuração rápida e quer ver sua IA gerar código Python em tempo real, o smolagents fornece uma solução elegante. Ele lida com o estilo de prompting "ReAct" nos bastidores, permitindo que você se concentre no que o agente deve fazer, em vez de como ele encadeia suas etapas de raciocínio.

Destaques:

Setup minimalista e rápido

Execução direta de código Python

Ideal para automações simples

Estilo ReAct integrado

CrewAI

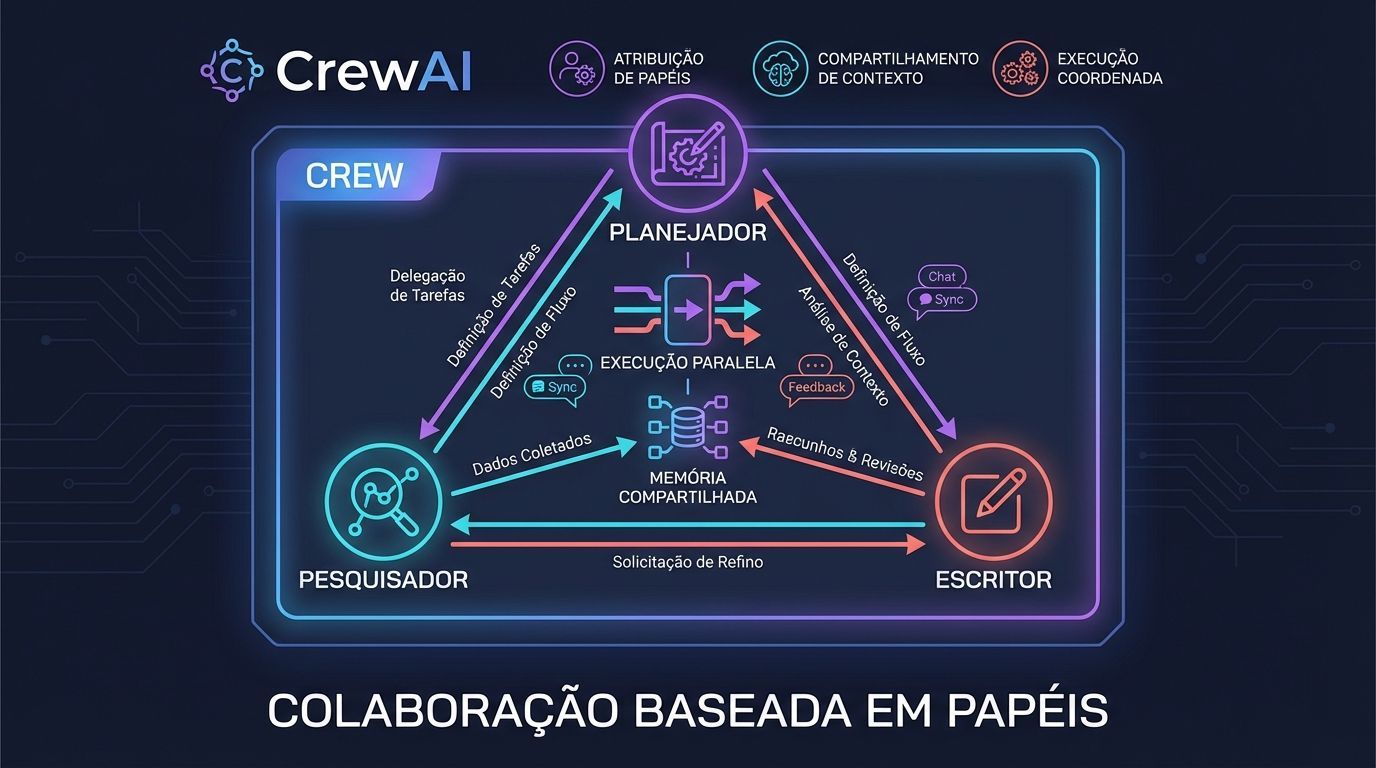

O CrewAI é totalmente voltado para colaboração baseada em papéis entre múltiplos agentes. Imagine dar a cada agente um conjunto de habilidades ou personalidade distinta, e então deixá-los cooperar (ou até debater) para resolver um problema. Este framework oferece uma abstração de nível superior chamada "Crew", que é basicamente um container para múltiplos agentes, cada um com um papel ou função. A Crew coordena workflows, permitindo que esses agentes compartilhem contexto e construam sobre as contribuições uns dos outros. O CrewAI se destaca por ser fácil de configurar enquanto ainda permite anexar lógica avançada de memória e tratamento de erros.

Se seu caso de uso exige uma abordagem multi-agent — como um agente "Planejador" delegando tarefas para agentes "Pesquisador" e "Escritor" — o CrewAI torna isso fácil. Os módulos de memória integrados e a experiência de usuário fluida levaram à crescente adoção onde colaboração e paralelização de tarefas são importantes.

Quando usar CrewAI:

Tarefas que requerem múltiplos especialistas

Workflows paralelos baseados em papéis

Necessidade de memória compartilhada entre agentes

Colaboração complexa entre diferentes skillsets

AutoGen

O AutoGen, nascido da Microsoft Research, enquadra tudo como uma conversa assíncrona entre agentes especializados. Cada agente pode ser um assistente estilo ChatGPT ou um executor de ferramentas, e você orquestra como eles passam mensagens uns para os outros. Esta abordagem assíncrona reduz bloqueios, tornando-a adequada para tarefas mais longas ou cenários onde um agente precisa esperar por eventos externos. Desenvolvedores que gostam da ideia de "múltiplos LLMs em conversação" podem achar a abordagem orientada a eventos do AutoGen interessante, especialmente para diálogos dinâmicos que precisam de concorrência em tempo real ou mudança frequente de papéis.

O AutoGen é excelente se você está construindo um agente que depende fortemente de conversas multi-turn e invocação de ferramentas em tempo real. Ele suporta chat de forma livre entre muitos agentes e é apoiado por uma comunidade orientada por pesquisa que consistentemente introduz novos padrões de conversação.

Vantagens do AutoGen:

Arquitetura event-driven

Suporte para múltiplos LLMs interagindo

Ideal para conversas em tempo real

Comunidade ativa de pesquisa

Semantic Kernel

O Semantic Kernel é a abordagem .NET-first da Microsoft para orquestrar "skills" de IA e combiná-las em planos ou workflows completos. Ele suporta múltiplas linguagens de programação (C#, Python, Java) e foca em prontidão empresarial, como segurança, conformidade e integração com serviços Azure. Em vez de limitá-lo a um único orquestrador, você pode criar uma gama de "skills", algumas alimentadas por IA, outras por código puro, e combiná-las. Este design o torna popular entre equipes que querem incorporar IA em processos de negócios existentes sem uma reescrita completa de sua pilha tecnológica.

Se você quer uma abordagem mais formal que mescla serviços de IA com não-IA, o Semantic Kernel é uma aposta forte. Ele tem uma abstração de "Planner" estruturada que pode lidar com tarefas de múltiplas etapas, tornando-o adequado para aplicações empresariais de missão crítica.

Ideal para:

Ambientes corporativos

Ecossistemas .NET

Integração com Azure

Conformidade e segurança empresarial

🦙 LlamaIndex Agents

O LlamaIndex começou como uma solução de retrieval-augmented generation para alimentar chatbots com grandes conjuntos de documentos. Com o tempo, adicionou capacidades semelhantes a agentes para encadear consultas e incorporar fontes de conhecimento externas. Os agentes do LlamaIndex são excelentes quando sua necessidade principal é recuperar dados de armazenamentos locais ou externos e fundir essas informações em respostas ou ações coerentes. As ferramentas em torno de indexação de dados, chunking de texto e ponte do seu LLM com uma base de conhecimento são de primeira linha, e essa abordagem centrada em dados se estende à camada de agente.

Se você está resolvendo tarefas pesadas em dados — como responder perguntas sobre documentos privados, resumir grandes repositórios ou construir um agente de busca especializado — os agentes LlamaIndex podem ser exatamente o que você precisa. A experiência de desenvolvimento parece intuitiva se você já usou o LlamaIndex para recuperação, e combina bem com outros frameworks que focam em orquestração.

Pontos fortes:

Excelente para RAG (Retrieval-Augmented Generation)

Ferramentas robustas de indexação

Integração natural com bases de conhecimento

Ideal para aplicações data-heavy

Strands Agents

O Strands Agents SDK é um framework de agentes model-agnostic que roda em qualquer lugar e suporta múltiplos provedores de modelo com raciocínio e uso de ferramentas, incluindo Amazon Bedrock, Anthropic, OpenAI, Ollama e outros via LiteLLM. Ele enfatiza prontidão para produção com tracing OpenTelemetry de primeira classe e integrações AWS opcionais profundas. Isso proporciona observabilidade de ponta a ponta com uma API limpa e declarativa para definir comportamento de agente.

O Strands Agents roda em qualquer lugar (AWS, outras clouds ou on-premise). Se você está na AWS, pode optar por integrações profundas com Bedrock; caso contrário, use qualquer provedor (Anthropic, OpenAI, Ollama, etc.) via LiteLLM — enquanto ainda combina bem com o pipeline de observabilidade do Langfuse.

Diferenciais:

Model-agnostic e flexível

Suporte OpenTelemetry nativo

Integrações opcionais com AWS

Deploy em qualquer ambiente

🐍 Pydantic AI Agents

O Pydantic AI traz a famosa type safety do Pydantic e experiência ergonômica de desenvolvedor para o desenvolvimento de agentes. Você define as entradas do seu agente, assinaturas de ferramentas e saídas como tipos Python, e o framework lida com validação mais instrumentação OpenTelemetry por baixo dos panos. O resultado é uma DX estilo FastAPI para aplicações GenAI.

Se você é um desenvolvedor Python que valoriza contratos de tipo explícitos, testes e loops de feedback rápidos, o Pydantic AI oferece um caminho leve, mas poderoso, para construir agentes prontos para produção com boilerplate mínimo.

Por que escolher Pydantic AI:

Type safety forte

Developer experience excepcional

Validação automática

Integração natural com FastAPI

Ideal para desenvolvedores Python

Tabela comparativa dos frameworks

Framework | Paradigma Central | Principal Força | Melhor Para |

|---|---|---|---|

LangGraph | Workflow baseado em grafo | Controle DAG explícito, branching, debugging | Tarefas multi-step complexas com branching, error handling avançado |

OpenAI Agents SDK | Toolchain OpenAI de alto nível | Ferramentas integradas como web e file search | Times que dependem do ecossistema OpenAI |

Smolagents | Loop de agente minimalista centrado em código | Setup simples, execução direta de código | Tarefas de automação rápida sem overhead de orquestração |

CrewAI | Colaboração multi-agent (crews) | Workflows paralelos baseados em papéis, memória | Tarefas complexas requerendo múltiplos especialistas |

AutoGen | Chat multi-agent assíncrono | Conversas ao vivo, event-driven | Cenários com concorrência em tempo real |

Semantic Kernel | Baseado em skills, integrações enterprise | Multi-linguagem, conformidade empresarial | Ambientes enterprise, ecossistemas .NET |

LlamaIndex Agents | RAG com indexação integrada | Sinergia entre retrieval e agente | Use-cases que giram em torno de lookup extensivo de dados |

Strands Agents | Toolkit de agente model-agnostic | Multi-modelo via LiteLLM; observabilidade OTEL forte | Times precisando de agentes flexíveis com tracing em produção |

Pydantic AI | Framework de agente Python type-safe | Type safety forte e DX estilo FastAPI | Desenvolvedores Python querendo lógica estruturada |

Quando usar cada framework

Em vez de prescrever uma ferramenta específica, é mais importante focar nas variáveis de alto nível que devem guiar sua decisão:

Complexidade da tarefa e estrutura do workflow

Determine se sua tarefa é simples ou requer raciocínio complexo de múltiplas etapas. Workflows complexos podem se beneficiar de orquestração explícita (como uma abordagem baseada em grafo ou skills), enquanto tarefas mais simples podem ser bem servidas por uma solução leve e centrada em código.

Colaboração e multi-agents

Verifique se seu projeto precisa de múltiplos agentes com papéis distintos interagindo de forma coordenada. A colaboração multi-agent pode exigir uma arquitetura que suporte conversas assíncronas e delegação de papéis.

Integrações

Considere os ambientes e sistemas com os quais seus agentes precisam interagir. Alguns frameworks fornecem integração mais fácil para chamadas de ferramentas, enquanto outros são projetados para prototipagem rápida e configuração mínima.

Performance e escalabilidade

Pense nas demandas de performance da sua aplicação. Alta concorrência e interações em tempo real podem necessitar de uma arquitetura event-driven. Ferramentas de observabilidade tornam-se cruciais aqui, permitindo rastrear o comportamento do agente e otimizar a performance ao longo do tempo.

Por que tracing e observabilidade de agentes são importantes

Frameworks de agentes envolvem muitas peças móveis. Cada agente pode chamar APIs externas, recuperar dados ou tomar decisões que ramificam em novas subtarefas. Rastrear o que aconteceu, por que aconteceu e como aconteceu é vital, especialmente em produção.

Ferramentas de observabilidade como o Langfuse permitem capturar, visualizar e analisar "traces" de agentes para que você possa ver cada prompt, resposta e chamada de ferramenta em uma linha do tempo estruturada. Esse insight torna o debugging muito mais simples e ajuda você a refinar prompts, medir performance e garantir que sua IA se comporte conforme esperado.

Benefícios do tracing com Langfuse

Debugging facilitado: Visualize cada etapa da execução do agente

Otimização de prompts: Identifique onde melhorar suas instruções

Análise de performance: Meça tempo de resposta e custos

Validação de comportamento: Confirme que o agente age como esperado

Compliance e auditoria: Mantenha registros detalhados das ações

FAQ sobre frameworks de agentes de IA

Qual framework devo escolher se estou começando?

Se você está começando e quer rapidez, considere o Smolagents para tarefas simples ou o OpenAI Agents SDK se já usa modelos OpenAI. Para projetos mais complexos desde o início, o LangGraph oferece controle granular.

É possível combinar diferentes frameworks?

Sim, muitos desenvolvedores usam frameworks complementares. Por exemplo, você pode usar LlamaIndex para retrieval e LangGraph para orquestração, ou Pydantic AI para validação de tipos junto com outro framework de agentes.

Como garantir que meus agentes sejam confiáveis em produção?

Implemente observabilidade desde o início usando ferramentas como Langfuse. Combine isso com testes automatizados, validação de outputs e monitoramento contínuo de métricas de performance e custos.

Qual framework tem melhor suporte da comunidade?

LangChain/LangGraph e AutoGen têm comunidades muito ativas. CrewAI também cresceu rapidamente em popularidade. O OpenAI Agents SDK, sendo mais novo, tem suporte oficial da OpenAI mas comunidade menor.

Posso usar esses frameworks com modelos locais?

Sim! Frameworks como Smolagents, LangGraph, AutoGen e Strands Agents suportam modelos locais via Ollama ou outras integrações. Isso é especialmente útil para requisitos de privacidade ou redução de custos.

Conclusão

A escolha do framework de agentes de IA certo depende fundamentalmente das suas necessidades específicas. Soluções baseadas em grafos como o LangGraph oferecem controle preciso, enquanto soluções baseadas em conversação como o AutoGen proporcionam diálogos naturais e flexíveis. A orquestração baseada em papéis do CrewAI pode resolver tarefas complexas através de um "elenco" de agentes especializados, enquanto o Smolagents é ideal para padrões minimalistas orientados por código.

O Semantic Kernel está posicionado no espaço empresarial, e os agentes LlamaIndex brilham para aplicações centradas em retrieval. O OpenAI Agents SDK atrai usuários já confiantes no stack OpenAI. O Strands Agents é model-agnostic com integrações AWS opcionais profundas, e o Pydantic AI é adaptado para ambientes Python.

Independentemente da escolha, lembre-se de que observabilidade não é opcional em produção. Ferramentas como o Langfuse ajudam você a entender, debugar e otimizar seus agentes, garantindo que eles entreguem valor real ao seu negócio.

A evolução desses frameworks está apenas começando, e 2025 promete trazer ainda mais inovações no campo dos agentes de IA. O importante é começar com o framework que melhor se alinha aos seus objetivos imediatos, sabendo que você pode evoluir e adaptar sua arquitetura conforme suas necessidades crescem.